nl.hideout-lastation.com

nl.hideout-lastation.com

10 Web Scraping Tools om online gegevens te extraheren

Web Scraping-tools zijn speciaal ontwikkeld voor het extraheren van informatie van websites. Ze staan ook bekend als hulpmiddelen voor het oogsten van het web of hulpmiddelen voor het extraheren van webgegevens. Deze hulpprogramma's zijn handig voor iedereen die een of andere vorm van gegevens van internet probeert te verzamelen . Web Scraping is de nieuwe techniek voor gegevensinvoer die geen herhaald typen of kopiëren of plakken vereist.

Deze software zoekt handmatig of automatisch naar nieuwe gegevens, haalt de nieuwe of bijgewerkte gegevens op en slaat ze op voor eenvoudige toegang. Men kan bijvoorbeeld met behulp van een scraping-tool informatie over producten en hun prijzen verzamelen bij Amazon. In dit bericht geven we een overzicht van de use-cases van webscraping-tools en de top 10 webscraping-tools om informatie te verzamelen, zonder codering.

Gebruik Cases of Web Scraping Tools

Web Scraping-tools kunnen voor verschillende doeleinden in verschillende scenario's worden gebruikt, maar we gaan een aantal algemene gebruikscasussen gebruiken die van toepassing zijn op algemene gebruikers.

Verzamel gegevens voor marktonderzoek

Web-scraptools kunnen u helpen op de hoogte te blijven van waar uw bedrijf of sector de komende zes maanden naartoe gaat, en dienen als een krachtig hulpmiddel voor marktonderzoek. De hulpprogramma's kunnen worden opgehaald door meerdere leveranciers van gegevensanalyses en marktonderzoeksbureaus en kunnen worden samengevoegd tot één locatie voor eenvoudige referentie en analyse.

Extract Contact Info

Deze tools kunnen ook worden gebruikt om gegevens zoals e-mails en telefoonnummers van verschillende websites te extraheren, waardoor het mogelijk is om een lijst met leveranciers, fabrikanten en andere personen van interesses bij uw bedrijf of bedrijf te hebben, naast hun respectieve contactadressen.

Download oplossingen van StackOverflow

Met behulp van een webschrapingtool kan men ook oplossingen voor offline lezen of opslag downloaden door gegevens van meerdere sites te verzamelen (waaronder StackOverflow en meer Q & A-websites). Dit vermindert de afhankelijkheid van actieve internetverbindingen omdat de bronnen gemakkelijk beschikbaar zijn ondanks de beschikbaarheid van internettoegang.

Zoek naar banen of kandidaten

Voor personeel dat actief op zoek is naar meer kandidaten om lid te worden van hun team, of voor werkzoekenden die op zoek zijn naar een bepaalde rol of vacature, werken deze hulpmiddelen ook uitstekend om moeiteloos gegevens op te halen op basis van verschillende toegepaste filters en om gegevens effectief zonder handleiding op te halen zoekopdrachten.

Volg prijzen van meerdere markten

Als u online winkelen leuk vindt en graag de prijzen van producten zoekt die u zoekt op meerdere markten en online winkels, dan heeft u zeker een webschrapingstool nodig.

10 Beste webschrapingstools

Laten we een kijkje nemen naar de 10 beste beschikbare webschrapingtools. Sommigen van hen zijn gratis, sommige hebben proefperioden en premium-plannen. Bekijk de details voordat u zich voor iemand abonneert op uw behoeften.

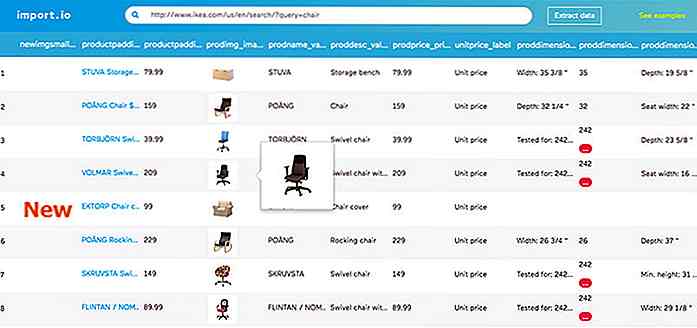

Import.io

Import.io biedt een builder om uw eigen gegevenssets te maken door eenvoudig de gegevens van een bepaalde webpagina te importeren en de gegevens naar CSV te exporteren. U kunt duizenden webpagina's eenvoudig binnen enkele minuten schrapen zonder een enkele regel code te schrijven en 1000+ API's te bouwen op basis van uw vereisten .

Import.io maakt gebruik van de allernieuwste technologie om elke dag miljoenen gegevens op te halen, die bedrijven kunnen gebruiken voor kleine bedragen. Samen met de webtool biedt het ook gratis apps voor Windows, Mac OS X en Linux om datatextractors en crawlers te bouwen, gegevens te downloaden en te synchroniseren met het online account.

Webhose.io

Webhose.io Webhose.io biedt directe toegang tot realtime en gestructureerde gegevens door duizenden online bronnen te doorzoeken. De webschraper ondersteunt het extraheren van webgegevens in meer dan 240 talen en het opslaan van de uitvoergegevens in verschillende formaten, waaronder XML, JSON en RSS .

Webhose.io is een browsergebaseerde webapp die een exclusieve datacrawling-technologie gebruikt om enorme hoeveelheden gegevens van meerdere kanalen in één API te crawlen. Het biedt een gratis abonnement voor het maken van 1000 verzoeken / maand en een $ 50 / mth premieplan voor 5000 verzoeken / maand.

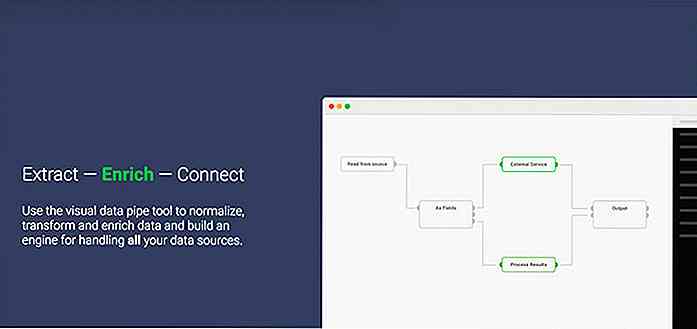

Dexi.io (voorheen bekend als CloudScrape)

Dexi.io (voorheen bekend als CloudScrape) CloudScrape ondersteunt het verzamelen van gegevens vanaf elke website en vereist geen download, net als Webhose. Het biedt een browser-gebaseerde editor om crawlers in te stellen en gegevens in realtime te extraheren. U kunt de verzamelde gegevens opslaan op cloudplatformen zoals Google Drive en Box.net of exporteren als CSV of JSON.

CloudScrape ondersteunt ook anonieme gegevenstoegang door een reeks proxyservers aan te bieden om uw identiteit te verbergen. CloudScrape slaat uw gegevens twee weken op de servers op voordat deze worden gearchiveerd. De webschraper biedt 20 uren schrapen gratis en kost $ 29 per maand.

Scrapinghub

Scrapinghub Scrapinghub is een data-extractietool in de cloud waarmee duizenden ontwikkelaars waardevolle gegevens kunnen ophalen. Scrapinghub maakt gebruik van Crawlera, een slimme proxyrotator die het omzeilen van bot-tegenmaatregelen ondersteunt om met gemak enorme of bot-beschermde sites te doorzoeken.

Scrapinghub converteert de hele webpagina naar georganiseerde inhoud . Het team van experts is beschikbaar voor hulp in het geval dat de crawlerbouwer niet aan uw vereisten kan voldoen. Het eenvoudige gratis abonnement geeft u toegang tot 1 gelijktijdige crawl en het premium-abonnement voor $ 25 per maand biedt toegang tot maximaal vier parallelle crawls.

ParseHub

ParseHub ParseHub is gebouwd om enkele en meerdere websites te crawlen met ondersteuning voor JavaScript, AJAX, sessies, cookies en doorverwijzingen. De toepassing maakt gebruik van machine learning-technologie om de meest gecompliceerde documenten op het web te herkennen en genereert het uitvoerbestand op basis van het vereiste gegevensformaat.

ParseHub is, naast de web-app, ook beschikbaar als een gratis desktop-applicatie voor Windows, Mac OS X en Linux, die een eenvoudig basisplan biedt voor 5 crawlprojecten. Deze service biedt een premium abonnement voor $ 89 per maand met ondersteuning voor 20 projecten en 10.000 webpagina's per crawl.

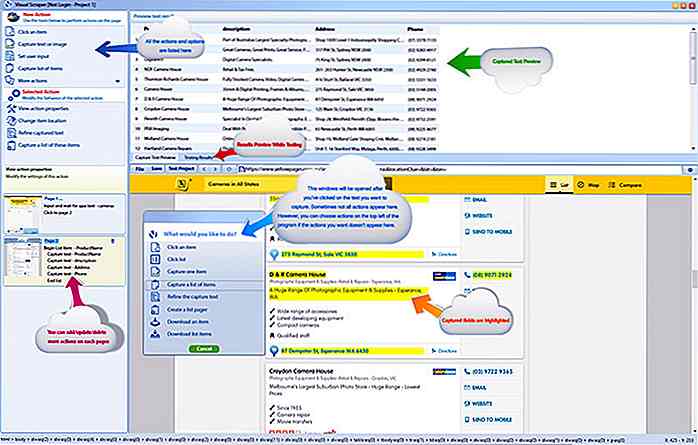

VisualScraper

VisualScraper VisualScraper is een andere software voor het onttrekken van webgegevens, die kan worden gebruikt om informatie van het web te verzamelen. De software helpt u bij het extraheren van gegevens van verschillende webpagina's en haalt de resultaten in realtime op. Bovendien kunt u exporteren in verschillende indelingen zoals CSV, XML, JSON en SQL .

U kunt eenvoudig webgegevens verzamelen en beheren met de eenvoudige aanwijsinterface . VisualScraper wordt gratis geleverd en premium-abonnementen vanaf $ 49 per maand met toegang tot 100K + pagina's. De gratis applicatie, vergelijkbaar met die van Parsehub, is beschikbaar voor Windows met extra C ++ -pakketten.

Spinn3r

Spinn3r Met Spinn3r kunt u volledige gegevens ophalen van blogs, nieuws- en sociale-mediasites en RSS- en ATOM-feeds. Spinn3r wordt gedistribueerd met een firehouse API die 95% van het indexeringswerk beheert . Het biedt een geavanceerde spambescherming, die spam en ongepast taalgebruik verwijdert, waardoor de veiligheid van gegevens wordt verbeterd.

Spinn3r indexeert inhoud vergelijkbaar met Google en slaat de geëxtraheerde gegevens op in JSON-bestanden. De webschraper scant voortdurend het web en vindt updates uit meerdere bronnen om u realtime-publicaties te krijgen. Met de beheerdersconsole kunt u crawls beheren en bij zoeken in volledige tekst kunt u complexe query's uitvoeren op onbewerkte gegevens .

80legs

80legs 80legs is een krachtige en toch flexibele tool voor het crawlen van websites die kan worden geconfigureerd volgens uw behoeften. Het ondersteunt het ophalen van enorme hoeveelheden gegevens samen met de optie om de geëxtraheerde gegevens onmiddellijk te downloaden. De webschraper claimt 600.000+ domeinen te crawlen en wordt gebruikt door grote spelers zoals MailChimp en PayPal.

Met de ' Datafiniti ' kunt u snel de volledige gegevens doorzoeken . 80legs biedt krachtige webcrawl die snel werkt en vereiste gegevens binnen enkele seconden ophaalt. Het biedt een gratis abonnement voor 10.000 URL's per crawl en kan worden geüpgraded naar een intro-abonnement voor $ 29 per maand voor 100.000 URL's per crawl.

krabber

krabber Scraper is een Chrome-extensie met beperkte gegevens-extractiefuncties, maar het is handig voor het maken van online onderzoek en het exporteren van gegevens naar Google Spreadsheets . Deze tool is bedoeld voor zowel beginners als experts die gemakkelijk gegevens kunnen kopiëren naar het klembord of opslaan in de spreadsheets met behulp van OAuth.

Scraper is een gratis tool die precies in je browser werkt en automatisch kleinere XPaths genereert voor het definiëren van te crawlen URL's. Het biedt je niet het gemak van automatisch crawlen of botten zoals Import, Webhose en andere, maar het is ook een voordeel voor beginners omdat je geen rommelige configuratie hoeft aan te pakken .

OutWit Hub

OutWit Hub OutWit Hub is een Firefox-add-on met tientallen functies voor het extraheren van gegevens om uw zoekopdrachten op het web te vereenvoudigen. Deze tool kan automatisch door pagina's bladeren en de geëxtraheerde informatie in een goed formaat opslaan. OutWit Hub biedt een enkele interface voor het schrapen van kleine of enorme hoeveelheden gegevens per behoefte.

Met OutWit Hub kunt u elke webpagina schrapen vanuit de browser zelf en zelfs automatische agents maken om gegevens te extraheren en te formatteren per instellingen. Het is een van de eenvoudigste webschrapingtools, die gratis te gebruiken is en u het gemak biedt om webgegevens te extraheren zonder een enkele regel code te schrijven.

Welke is je favoriete webschrapingstool of add-on? Welke gegevens wilt u uit het internet halen? Deel uw verhaal met ons via de opmerkingen hieronder.

Welke is je favoriete webschrapingstool of add-on? Welke gegevens wilt u uit het internet halen? Deel uw verhaal met ons via de opmerkingen hieronder.

Milligram.css - Minimalistische Frontend-bibliotheek voor ontwikkelaars

Van Bootstrap tot Foundation is er geen tekort aan aangepaste CSS-bibliotheken. Maar wat als u een heel eenvoudige lichtgewichtoptie nodig heeft voor nieuwe webprojecten? Veel bestaande CSS-bibliotheken zijn zwaar en hebben te veel functies .Maar Milligram is een superlichtgewicht alternatief van in totaal ongeveer 8 KB in een verkleind CSS-bestand

20 websites om gratis afbeeldingen van hoge kwaliteit te vinden

De kans is groot dat je het beu bent om traditionele stockfoto's te zien van mensen in pak die handen schudden. Niet alleen zijn ze flauw en oninteressant, maar ze kosten ook geld. Het goede nieuws is dat er een toename is van grote stockfotosites die u gratis kunt gebruiken - ja, voor zowel persoonlijk als commercieel gebruik